数理统计和多元统计知识点汇总

分布函数

0-1分布

$X \sim B(1,p)$

$P\{x=k\} = p^k(1-p)^{1-k} \quad k=0,1$

$E(X) = p \qquad D(X) = p(1-p)$

几何分布

$P(A) = p$

第k次首次发生,前k-1次均为发生。

$P\{x=k\} = (1-p)^{k-1}p$

二项分布 baibinomial

$X \sim B(n,p)$

$P(A)=p$

n次实验发生了k次。

$P\{x = k\} = C_n^kp^k(1-p)^{n-k} \quad k = 0,1,2,…,n$

$E(X)=np \qquad D(X)=np(1-p)$

泊松分布 poisson

$X \sim \pi(\lambda)$

$P\{x=k\} = \frac{\lambda^k}{k!} e^{-\lambda} \quad k=1,2,… \quad \lambda > 0$

$E(X) = \lambda \qquad D(X)=\lambda$

均匀分布 uniforn

$X \sim U[a,b]$

$f(x) = \begin{cases}

\frac{1}{b-a} & & a\leq x \leq b \\\\

0 & & 其它

\end{cases}$

$F(x) = \begin{cases}

0 & & x<a \\\\

\frac{x-a}{b-a} & & a \leq x <b \\\\

1 & & x \geq b

\end{cases}$

$E(X)= \frac{a+b}{2} \qquad D(X) = \frac{(b-a)^2}{12}$

指数分布 exponential

$X \sim E(\lambda)$

$f(x) = \begin{cases}

\lambda e ^{-\lambda x} & & x>0 \\\\

0 & & x\leq 0

\end{cases} \quad \lambda > 0$

$F(x)= \begin{cases}

1-e^{- \lambda x} & & x>0\\\\

0 & & x\leq 0

\end{cases}$

$E(X) = \frac{1}{\lambda} \qquad D(X)=\frac{1}{\lambda^2}$

第一章

期望和方差的性质

- $E(c) = c$

- $E(aX+bY) = aE(X)+bE(Y)$

- $D(X)=E\{[X-E(X)]^2\}=E(X^2)-E(X)^2$

- $D(\sum\limits_{i=1}^nC_iX_i) = \sum\limits_{i=1}^n {C_i}^2 D(X_i)$

正态分布的性质

$f(x)=\frac{1}{\sqrt{2\pi}\sigma}e^{(\frac{-(x-\mu)^2}{2\sigma^2})}$

- $X \sim N(\mu , \sigma^2) \rightarrow X-a \sim N(\mu-a,\sigma^2)$

- $X \sim N(\mu , \sigma^2) \rightarrow aX \sim N(a\mu,a^2\sigma^2)$

$X \sim N({\mu}_x , {\sigma_x}^2) ,Y \sim N({\mu}_y , {\sigma_y}^2)$

$X+Y \sim N(\mu_x+\mu_y,{\sigma_x}^2+{\sigma_y}^2)$

$X-Y \sim N(\mu_x-\mu_y,{\sigma_x}^2+{\sigma_y}^2)$

$z_\alpha$为$N(0,1)分布的$上$\alpha$分为点。$z_\alpha = -z_{1-\alpha}$

常见统计量

- 样本方差: $S^2=\frac{1}{n-1}\sum\limits_{i=1}^n(X_i-\bar{X})^2$

- 标准差: $S=\sqrt{S^2}$

- 二阶中心距: ${S_n}^2=\frac{1}{n}\sum\limits_{i=1}^n(X_i-\bar{X})^2$

- 次序统计量: $X_{(i)}$为$(X_1,X_2,…,X_n)$中第$i$大的值。

$\chi^2$分布及其性质

$X_1,X_2,…,X_n \sim N(0,1)$

$Y \stackrel{def}{\rightarrow}\sum\limits_{i=1}^n{X_i}^2 \sim \chi^2(n)$

- $E(\chi^2(n))=n$

- $D(\chi^2(n))=2n$

- $X\sim\chi^2(n),Y\sim\chi^2(m) \rightarrow X+Y\sim\chi^2(n+m)$

$n \leq 45$时,$\chi^2_{\alpha}(n)$直接查表,当$n>45$时,$\chi^2_{\alpha}(n) \approx \frac{1}{2}(z_\alpha+\sqrt{2n-1})^2$

t分布及其性质

$X \sim N(0,1), Y\sim\chi^2(n)$,$X$与$Y$相互独立。

$T \stackrel{def}{\rightarrow} \frac{X}{\sqrt{ {Y}/{n} } } \sim t(n)$

- $t_{\alpha}(n)=-t_{1-{\alpha}}(n)$

F分布及其性质

$X\sim\chi^2(n),Y\sim\chi^2(m)$,$X$与$Y$相互独立。

$F \stackrel{def}{\rightarrow}\frac{X/n}{Y/m} \sim F(n,m)$

- $F_{\alpha}(n,m)=\frac{1}{F_{1-{\alpha}}(m,n)}$

第二章

正态总体分布单样本抽样定理

设$(X_1,X_2,…,X_n)$是取自总体$N(\mu,\sigma^2)$的一组简单随机样本,则有:

- $\bar{X}\sim N(\mu,\frac{\sigma^2}{n}) \stackrel{标准化}{\rightarrow} \frac{\bar{X}-\mu}{\sigma/\sqrt{(n)}}\sim N(0,1)$

- $\sum\limits_{i=1}^n(\frac{X_i-\mu}{\sigma})^2 = \frac{1}{\sigma^2}\sum\limits_{i=1}^n(X_i-\mu)^2\sim\chi^2(n)$

- $\frac{(n-1)S^2}{\sigma^2}=\frac{nS_n^2}{\sigma^2}\sim\chi^2(n-1)$

- $\bar{X}$与$S^2$ 相互独立

- $\frac{\bar{X}-\mu}{S/\sqrt{n}} = \frac{\bar{X}-\mu}{S_n/\sqrt{n-1}}\sim t(n-1)$

正态分布双样本抽样定理

$(X_1,X_2,…,X_n)$取自$X\sim N(\mu_1,{\sigma_1}^2)$, $(Y_1,Y_2,…,Y_m)$取自$Y\sim N(\mu_2,{\sigma_2}^2)$

$X$与$Y$相互独立,则:

$\bar{X}\sim N(\mu_1,\frac{\sigma_1^2}{n})$, $\bar{Y}\sim N(\mu_2,\frac{\sigma_2^2}{m})$

$\bar{X}-\bar{Y}\sim N(\mu_1-\mu_2,\frac{\sigma_1^2}{n}+\frac{\sigma_2^2}{m})$

$\frac{(\bar{X}-\bar{Y})-(\mu_1-\mu_2)}{\sqrt{(\frac{\sigma_1^2}{n}+\frac{\sigma_2^2}{m})}}\sim N(0,1)$

$\frac{(n-1)S_1^2}{ { \sigma_1}^2} \sim \chi^2(n-1), \frac{(m-1)S_2^2}{ { \sigma_2}^2} \sim \chi^2(m-1)$

$\frac{(n-1)S_1^2}{ {\sigma_1}^2} + \frac{(m-1)S_2^2}{ {\sigma_2}^2} \sim \chi^2(n+m-2)$

当$\sigma_1^2=\sigma_2^2$时:

$\frac{(n-1)S_1^2+(m-1)S_2^2}{\sigma^2}\sim \chi^2(n+m-2)$

$\frac{(n-1)S_1^2}{ {\sigma_1}^2} \sim \chi^2(n-1), \frac{(m-1)S_2^2}{ {\sigma_2}^2} \sim \chi^2(m-1)$

$\frac{S_1^2/\sigma_1^2}{S_2^2/\sigma_2^2}\sim F(n-1,m-1)$

矩估计

$E(X)=? \qquad E(X^2)=?$

$\theta=f(E(X),E(X^2),…)$

用$A_1,A_2,…$代替$E(X),E(X^2)$,$A_1=\frac{1}{n}\sum\limits_{i=1}^{n}X_i,A_2=\frac{1}{n}\sum\limits_{i=1}^{n}X_i^2$

$\hat{\theta}=f(A_1,A_2,…)$

极大似然估计

$L(X_1,X_2,…,X_n,\theta)=\prod\limits_{i=1}^nf(X_i,\theta)$

$\frac{\partial L_n(L)}{\partial \theta}=0$ 解得$\theta=\hat{\theta}$

$\frac{\partial^2 L_n(L)}{ {\partial \theta} ^2}|_{\theta=\hat {\theta} }<0$得$\hat\theta$为$\theta$的极大似然估计。

估计量和估计值

估计量:$X_1,X_2,…,X_n$表示出$\theta$。

估计值:用观测值$x_1,x_2,…,x_n$带入估计量求出$\theta$。

无偏性和有效性

$\hat\theta$为$\theta$的一个估计量,则$E(\hat\theta)=\theta \Rightarrow 无偏$,$D(\hat\theta)$越小,$\hat\theta$越有效。

置信区间

$P\{\underline{\theta}(X_1,X_2,…,X_n)\leq\theta\leq \overline\theta(X_1,X_2,…,X_n)\}\geq1-\alpha$

其中,$1-\alpha$称为置信度,区间$[\underline{\theta}(X_1,X_2,…,X_n),\overline\theta(X_1,X_2,…,X_n)]$称为未知参数$\theta$的置信度为$1-\alpha$的置信区间。

步骤:

- 点估计$\hat\theta$

- $J(\theta,\hat\theta),J分布已知,可查表$

- $P\{a\leq J(\theta,\hat\theta) \leq b\}\geq 1-\alpha \Rightarrow a,b(查表得a,b)$

- 由3变形得到 $\hat\theta\in[a’,b’]$

示例:

已知$N(\mu,\sigma^2)$的$\sigma^2$,求$\mu$的双侧$1-\alpha$的置信区间。

- 点估计$\hat\mu=\overline x$

- $P(\overline x \leq \mu \leq \overline x +b)=1-\alpha$

- 变形 $P(a’\leq \frac{\overline x - \mu}{\sigma/\sqrt n }\leq b’)=1-\alpha$

- 取$a’=-Z_{1-\frac{\alpha}{2}},b’=Z_{-\frac{\alpha}{2}}$

第三章

假设检验

原假设$H_0$,例$\mu=\mu_0$

备择假设$H_1$,例$\mu \neq \mu_0,\mu>\mu_0\And\mu<\mu_0$

显著性水平$\alpha$:表示容忍犯第一类错误概率的上限,通常较小。

结论:

- 当找到足够的证据支持备择假设则拒绝$H_0$,接受$H_1$。

- 当未找到足够的证据支持$H_1$,则拒绝$H_1$,接受$H_0$。

两类错误

| $H_0$成立 | $H_1$成立/$H_0$不成立 | |

|---|---|---|

| 接受$H_0$ | 正确 | 第一类错误 |

| 拒绝$H_0$ | 第二类错误 | 正确 |

$P(第一类错误)=P(拒绝H_0|H_0成立)=P(落入拒绝域|H_0成立)$

$P(第二类错误)=P(接受H_0|H_0不成立)=P(接受H_0|H_1成立)=P(未落入拒绝域|H_1成立)$

假设检验的基本步骤

- 建立原假设和备择假设,$H_0和H_1$。

- 求未知参数$\theta$的一个点估计$\hat\theta$

- 构造$J(\theta,\hat\theta)$,$J$分布已知

- 由$H_0,H_1和J(\theta,\hat\theta)$构造出$W$拒绝域

- 判定是否落入拒绝域$\Rightarrow 拒绝H_0/接受H_0$

其它分布的假设检验

比例$p$的假设检验

$X \sim B(1,p)$

$n\overline{X} = \sum\limits_{i=1}^nX_i \sim B(n,p)$

泊松分布的假设检验

$X \sim \pi(\lambda)$

$n\overline{X} = \sum\limits_{i=1}^nX_i \sim \pi(n\lambda)$

大样本检验

$X \sim B(1,p)$

$\frac{\overline{X}-p}{\sqrt{p(1-p)/n}}\sim N(0,1)$

$X \sim \pi(\lambda)$

$\frac{\overline{x}-\lambda}{\sqrt{\lambda/n}} \sim N(0,1)$

上面这两个都是中心极限定理得到的。

$\frac{\overline{x}-E(X)}{\sqrt{D(X)/n}} \sim N(0,1)$

指数分布的参数假设

$X \sim E(\lambda)$

$2n\lambda \overline{X} \sim \chi^{2}(2n)$

均匀分布的参数假设

$X \sim U(0,\theta)$

$J = \frac{X_{(n)}}{\theta}$

$

F_{J}(x) =

\begin{cases}

0 &,& x < 0\\\\

x^n &,& 0 \leq x\leq1 \\\\

1 &,& x >1

\end{cases}

$

卡方检验

- 假设$H_0$:样本服从某某分布, $H_1$: 样本不服从某某分布

- 用极大似然法估计分布函数中的未知参数。

- 使用分布函数的概率函数求出每个$\hat{p_i}$

- 计算$\sum\limits_{i=1}^r \frac{(n_i-n\hat p_i)^2}{n\hat p_i} = \hat\chi^2$

- 查表得$\chi_\alpha^2(r-m-1)$,$r$为分组的个数,$m$为使用极大似然估计估计的参数个数。

- 若$\hat\chi^2 > \chi_\alpha^2(r-m-1)$ 则不服从,若$\hat\chi^2 \leq \chi_\alpha^2(r-m-1)$ 则服从。

第四章

次序统计量

总体$X$的分布函数为$F(x)$,$X_{(r)}$的分布函数为$F_r(x)$

$F_r(x) = P\{X_{(r)}\leq x\} = P\{X_1,X_2,…,X_n中至少有r个取值小于等于x\}= \sum\limits_{j=r}^nC_n^jF(x)^j[1-F(x)]^{n-j} \quad r=(1,2,…,n)$

当$r=1$时,$F_r(x) = 1-[1-F(x)]^n$

当$r=n$时,$F_r(x) = F(x)^n$

极差

$R = X_{(n)} - X_{(1)}$

p分位数

$[\alpha]$为不超过$\alpha$的最大整数,则对任意的$0<p<1$,称$X_{([np]+1)}$是样本的p分为数,记为$\tilde{X_p}$

中位数

总数为奇数时为中间那个,偶数时,中间两个相加除以2。

秩统计量

每得到一组观测值$(x_1,…,x_n)$,将其由小到大排序,若$X_i$的观测值$x_i$排在第$r_i$位,就用$r_i$作为$R_i$的观测值,$(R_1,…,R_n)$称为秩统计量。

当样本中有重复值的时候,秩统计量需要求均值。

切尾均值

排序后去掉头尾各α%个数,再求均值。

Winsor化均值:

排序后去掉头尾各α%个数,用新的头尾的数填充头尾,使得数量不变,再求均值。

总体分位数的估计

设总体X的分布函数为$F(X)$,对于给定的$p(0<p<1)$称满足条件$F(\xi_p-0) \leq p \leq F(\xi_p)$ 的$\xi_p$为X分布的p分位数。 表示总体取值不超过它的概率刚好是p。

对给定的置信度$1-\alpha$,求r和s满足$P\{X_{(r)}\leq \xi_p \leq X_{(s)}\} \geq 1-\alpha$

这里只需要使$P\{\xi_p < X_{(r)}\}\leq \frac{\alpha}{2} \quad P\{\xi_p>X_{(s)}\}\leq \frac{\alpha}{2}$

查二项分布表得到r,s。

$r=max\{c|\sum\limits_{j=0}^{c-1} C_n^jp^j[1-p]^{n-j}\leq \frac{\alpha}{2}\}$

$s=min\{c|\sum\limits_{j=c}^{n} C_n^jp^j[1-p]^{n-j}\leq \frac{\alpha}{2}\}$

而有$\xi_p$的$1-\alpha$置信区间为:$[X_{(r)},X_{(s)}]$

总体分位数的检验

对于给定的$p(0<p<1)$,设总体的分布函数为$F(x)$,且$p$分位数$\xi_p$唯一。 假设检验:

$H_0:\xi_p =b(b为已知数) \qquad H_1:\xi_p \neq b$

令$Y_i = \begin{cases}

1 &,& X_i > b\\\\

0 &,& X_i \leq b

\end{cases}$

显著性水平$\alpha$下$H_0$的拒绝域为:

$W=\{(y_1,…,y_n)| \sum\limits_{i=1}^{n} y_i < c_1 \quad or \quad \sum\limits_{i=1}^{n}y_i > c_2\}$

其中:

$c_1=max\{d|\sum\limits_{j=0}^{d-1} C_n^jp^j[1-p]^{n-j}\leq \frac{\alpha}{2}\}$

$c_2=min\{d|\sum\limits_{j=d+1}^{n} C_n^jp^j[1-p]^{n-j}\leq \frac{\alpha}{2}\}$

第五章

回归分析研究变量间的什么关系?

回归分析研究变量间相关关系的有无和相关关系的形式。

阐述回归函数的作用和意义

回归函数刻画了自变量对因变量取值的主导作用。

回归分析的首要问题是什么?

回归分析的首要问题是推断回归函数的具体形式。

回归分析中随机误差项$\epsilon$的意义是什么?

$\epsilon$为随机波动,刻画的是随机因素综合作用的效果,均值为零。

在回归分析中,残差平方和的大小意味着什么? 什么情况下残差平方和为零?

残差平方和描述观测值和回归函数之间的拟合程度,当随机误差项$\epsilon$为0时,残差平方和为零。

简述在回归分析中用最小二乘法估计回归系数的基本思想

取使残差平方和达到最小的$\hat{b_0},\hat{b_2},…,\hat{b_n}$作为回归系数的估计。即使因变量对个个自变量的偏导数等与0,进而求出回归系数的最小二乘。

线性回归

$\hat y=\hat{b_0}+\hat{b_1}x_1+\hat{b_2}x_2+…+\hat{b_n}x_n$

为变量$y$关于变量$x_1,x_2,…,x_n$的经验回归方程。

当$p=1$时,一元线性回归模型为

$

\begin{cases}

y &=& a+bx+\epsilon \\\\

E(\epsilon) &=& 0

\end{cases}

$

关于$y$和$x$之间$n$次实验观测数据为$(x_i,y_i),(i=1,2,…,n)$

$

\begin{gathered}

Y = \begin{bmatrix}

y_1\\y_2\\ … \\y_n

\end{bmatrix}

\quad

X = \begin{bmatrix}

1 & x_1\\1 & x_2 \\ … & …\\ 1 & x_n

\end{bmatrix}

\beta =

\begin{pmatrix}

a \\ b

\end{pmatrix}

\end{gathered}

$

$\hat \beta = \hat{\begin{pmatrix}

a \\ b

\end{pmatrix}} = (X^TX)^{-1}X^TY$

$a = \frac{\overline{y}(\sum x_i^2)- \overline{x}(\sum x_iy_i)}{\sum(x_i-\overline{x})^2}$

$b = \frac{\sum(x_i-\overline{x})(y_i-\overline{y})}{\sum(x_i-\overline{x})^2}$

线性回归的显著性分析

对于$y=a+b_1x_1+b_2x_2+…+b_px_p$

$H_0:b_1=b_2=b_p=0 \quad H_1:b_1,b_2,…,b_p不全等与0$

拒绝域:$W = \{\frac{SS_{回}}{RSS}>\frac{p}{n-p-1}F_{\alpha}(p,n-p-1)\}$

残差平方和:$RSS = (Y-X\hat{\beta})^{‘}(Y-X\hat{\beta})= \sum\limits_{i=1}^{n}(y_i-\hat{y_i})^2 \quad \hat{y_i} = a+b_1x_{i1}+b_2x_{i2}+…+b_px_{ip}$

回归平方和:$SS_回 = \sum\limits_{i=1}^{n}(\hat{y_i}-\overline{y})^2$

总偏差平方和:$TSS = \sum\limits_{i=1}^{n}(y_i-\overline{y})^2 = RSS+SS_回$

误差方差的无偏估计$\sigma^2 = \frac{1}{n-p-1} RSS$

样本相关系数:$R=+\sqrt{R^2} \qquad R^2 \overset{def}{=} \frac{SS_回}{TSS}$

计算,带入,若落入拒绝域,则拒绝$H_0$,有线性关系,否则,接受$H_0$,没有线性关系。

两个总体的比较

问题形式:

给两个容量为$m$和$n$的样板$X,Y,(X_1,…,X_m) 和 (Y_1,…,Y_n)$

问:

- X和Y的分布是否相同/差不多(X=Y?)

- Y是否比较X变大,X是否较Y变大?

令$F(X)$和$G(X)$为$X$和$Y$的分布函数,$m,n$为$X$和$Y$的样本容量,有$P(X>Y)>\frac{1}{2} \leftrightarrow F(X)<G(X)$

令$Z:(Z_1,…,Z_{n+m}) = (X_1,…,X_m,Y_1,…,Y_n)$, $(R_1,…,R_{m+n})$ 为$Z$的秩统计量。

$T = \sum\limits_{i=1}^{m}R_i$为X在和样本中的秩和。

对于$X=Y$?

$H_0:F(X)=G(X) \qquad H_1:F(X)\neq G(X)$

拒绝域$W = \{T\leq C_1或 T\geq C_2\}$

要使得$P(T\leq C_1) \leq \frac{\alpha}{2}, \quad P(T \geq C_2) \leq \frac{\alpha}{2}$

查附表5求得$C_1$和$C_2$

得到$W$,判断T是否落入$W$,

若落入,则拒绝$H_0$,即$X \neq Y$

否则,接受$H_0$,即$X=Y$

对于X>Y?

$H_0:F(X)=G(X) \qquad H_1:F(X)\leq G(X)$

拒绝域$W = \{ T\geq C_2\}$

要使得$\quad P(T \geq C_2) \leq \alpha$

查附表5求得$C_2$

得到$W$,判断T是否落入$W$,

若落入,则拒绝$H_0$

否则,接受$H_0$

第六章

单因素方差分析

基本问题:判别因素$A$对结果影响是否显著。

描述:因素$A$有$s$个水平,$A_1,A_2,…,A_s$,第$i$个水平有$n_i$个样本,样本的观测值为要研究的结果的值。

基本假定:方差齐性:个水平方差相等。

假设检验:$H_0:\mu_1=\mu_2=…=\mu_s \quad H_1:\mu_1,\mu_2,…,\mu_s不全相等。$

总平均:$\overline{x} = \frac{1}{n}\sum\limits_{i=1}^s \sum\limits_{j=1}^{n_i}x_{ij}$

总变差平方和:$S_T^2 = \sum\limits_{i=1}^s \sum\limits_{j=1}^{n_i}(x_{ij}-\overline{x})^2$

水平$A_i$时的样本平均值:$\overline{x_i} = \frac{1}{n_i}\sum\limits_{j=1}^{n_i}x_{ij}$

组内平方和(误差平方和):$S_E^2 = \sum\limits_{i=1}^s \sum\limits_{j=1}^{n_i}(x_{ij}-\overline{x_i})^2$

组间平方和(因素平方和):$S_A^2 = \sum\limits_{i=1}^s \sum\limits_{j=1}^{n_i}(\overline{x_i}-\overline{x})^2$

$S_T^2 = S_A^2+S_E^2$

$W = \{\frac{(n-s)S_A^2}{(s-1)S_E^2} > F_\alpha(s-1,n-s)\}$

如果取$\alpha=0.01$时,$H_0$被拒绝,则称因素$A$对结果影响高度显著。

如果取$\alpha=0.01$时,$H_0$无法被拒绝,$\alpha=0.05$时,$H_0$被拒绝,则称因素$A$对结果影响显著。

如果取$\alpha=0.05$时,$H_0$无法被拒绝,$\alpha=0.1$时,$H_0$被拒绝,则称因素$A$对结果有一定影响。

如果取$\alpha=0.1$时,$H_0$仍无法被拒绝,则称因素$A$对结果无显著影响。

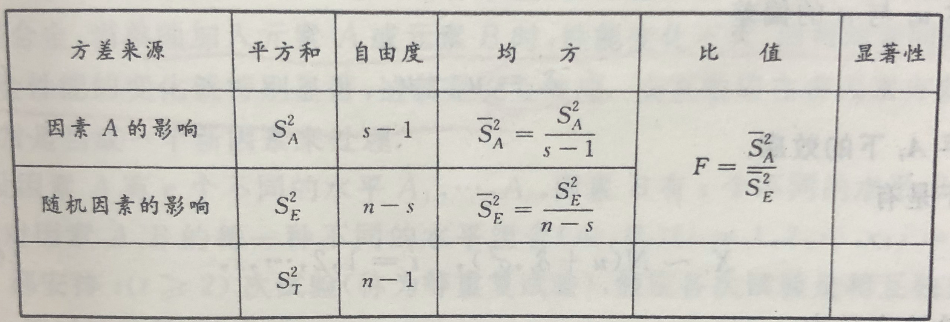

方差分析表

判别分析

基本问题:有两个$p$维总体$G_1,G_2$,$x=(x_1,…,x_p)^{‘}$是一$p$维样品,要判断$x$是来自$G_1$还是$G_2$。(或者是多个总体$G_1,G_2,…,G_n$)

距离判别法

基本思想:$x$属于距离$x$最近的总体$G_i$,用$\mu_i$均值向量代表$G_i$。

马氏距离:$D(x,G_i) = \sqrt{(x-\mu_i)^{‘} \sum_{i}^{-1}(x-\mu_i)}$

$\mu_i$表示总体$G_i$的均值向量,$\sum_i$表示总体$G_i$的协方差矩阵。

$\mu_i=\overline{x} = \frac{1}{n} \sum\limits_{k=1}^n x_{(k)}, x_{(k)}$为总体$G_i$中抽取的样本。

$\sum_i=S^2=\frac{1}{n-1} \sum\limits_{k=1}^n (x_{(k)}-\overline{x})(x_{(k)}-\overline{x})^{‘}$

取$k = \underset{i}{argmin}D(x,G_i),G_k$为$x$所属的总体。

Bayes判别法

考虑先验概率和判错损失,求一判别规则是的判错损失最小。

- 先验概率:$G_i$的出现概率为$q_i,\sum\limits_{i=1}^m q_i=1$

- 将$i$判错为$j$的损失:$C(j|i)\geq 0 \qquad C(i|i)=0$

- 将$i$判错为$j$的概率:$P(j|i,R) = \int_{R_j} f_i(x) dx$

- $i$造成的平均损失:$r(i,R)=\sum\limits_{i=1}^m [c(j|i)P(j|i,R)]$

- 总平均损失:$g(R)=\sum\limits_{i=1}^m q_ir(i,R)$

贝叶斯判别法的目标,适当的划分$R=R_1 \cup R_2\cup,…,\cup R_m$使得$g(R)$最小。

中间的步骤不写了, 反正最后两总体的划分如下:

$R_1 = \{x|\frac{f_1(x)}{f_2(x)} \geq \frac{c(1|2)q_2}{c(2|1)q_1}\}$

$R_2 = \{x|\frac{f_1(x)}{f_2(x)} < \frac{c(1|2)q_2}{c(2|1)q_1}\}$

$\frac{f_1(x)}{f_2(x)} = exp\{\frac{1}{2} (x-\mu_2)^{‘}\sum^{-1}(x-\mu_2) - \frac{1}{2} (x-\mu_1)^{‘}\sum^{-1}(x-\mu_1)\}$

主成分分析

基本问题:$n$个样本,$p$个指标,要降维到$m$个指标。

即:原先$x_{(i)}=(x_{i1},x_{i2},…,x_{ip})^{‘}$

降维后:$y_{(i)}=(y_{i1},y_{i2},…,y_{im})^{‘} = (l’_1x_{(i)},…,l’_mx_{(i)})$

求法:求解系数$C$

通过矩估计求的$\underset{p\times p}{\sum} = \frac{1}{n-1}\sum\limits_{i=1}^n(x_{(i)}-\overline{x})(x_{(i)}-\overline{x})^{‘} \quad \overline{x} = \frac{1}{n} \sum\limits_{i=1}^n x_{(i)}$

对$\sum$求特征值$\lambda_1,\lambda_2,…,\lambda_p$及其特征向量$P_1,P_2,…,P_p$,将特征向量标准化(模长为1)。

- 取前$m$大的$\lambda_i$和其对于的$P_i$

$\frac{\sum\limits_{i=1}^m \lambda_i}{\sum\limits_{i=1}^p \lambda_i}$ 称为前$m$个主成分的贡献率。

- $y_{i1}=P_1^{‘}x_{(i)},y_{i2}=P_2^{‘}x_{(i)},…$

要求第一主成分的方差达到最大意味着什么?

第一主成分方差达到最大意味着其包含的信息最多。

为什么要求个主成分之间的协方差为零?

因为主成分分析就是要求个主成分所包含的信息互不重叠,也就是要求它们互不关联,所以协方差为零。

聚类分析

基本问题:将$n$个$p$维样品,分成$k$类。

系统聚类:每次将距离最近的两个类合并成一个类,直到只剩一个类。

样本间距离:

- 绝对距离:$d(X,Y)=\sum\limits_{i=1}^P|x_i-y_i|$

- 欧式距离:$d(X,Y)=[\sum\limits_{i=1}^P(x_i-y_i)^2]^{\frac{1}{2}}$

- 切比雪夫距离:$d(X,Y)= \underset{1\leq i \leq P}{max} |x_i-y_i|$

- 闵可夫斯基距离:$d(X,Y)=[\sum\limits_{i=1}^P|x_i-y_i|^q]^{\frac{1}{q}}(q>0)$

- 马氏距离:$d(X,Y)=\sqrt {(x-y)^T \sum ^{-1} (x-y)}$

- 兰氏距离:$d(X,Y)=\frac{1}{p}\sum\limits_{i=1}^p\frac{|x_i-y_i|}{x_i+y_i}$

类间距离:

- 最短距离:$D_{pq}=min(d_{ij})$

- 最长距离:$D_{pq}=max(d_{ij})$

聚类画图法:

- 写距离表

- 合并距离最小的两类

- 重写距离表

- 合并

- …

- …

- 直到只有一类